| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- licence delete curl

- query

- aggregation

- Elasticsearch

- token filter test

- docker

- 900gle

- 파이썬

- high level client

- Mac

- aggs

- Java

- springboot

- zip 파일 암호화

- Python

- sort

- 차트

- API

- MySQL

- TensorFlow

- license delete

- License

- analyzer test

- Kafka

- flask

- matplotlib

- zip 암호화

- Test

- ELASTIC

- plugin

- Today

- Total

개발잡부

spark 본문

https://sparkbyexamples.com/spark/install-apache-spark-on-mac/

Install Apache Spark Latest Version on Mac - Spark by {Examples}

Five easy steps to install the latest version of Apache Spark on Mac (macOS) – In recent days Apache Spark installation on Mac OS has become very easy using Homebrew. You can install it and start running examples in just 5 mins. There are multiple ways t

sparkbyexamples.com

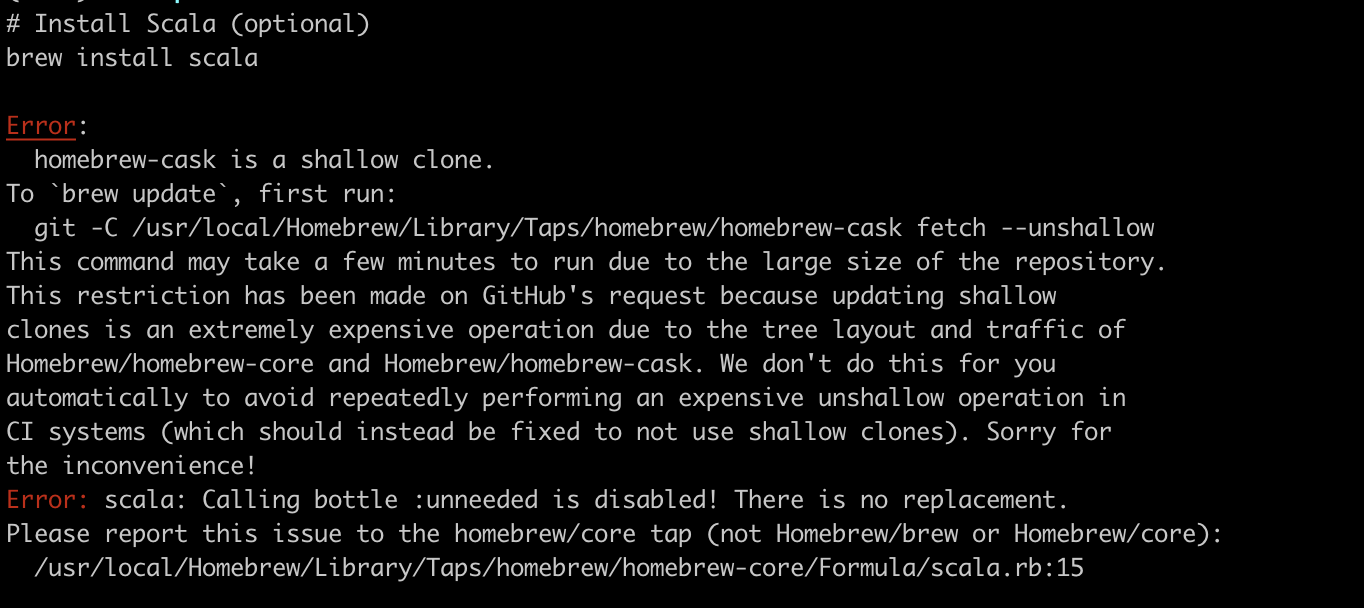

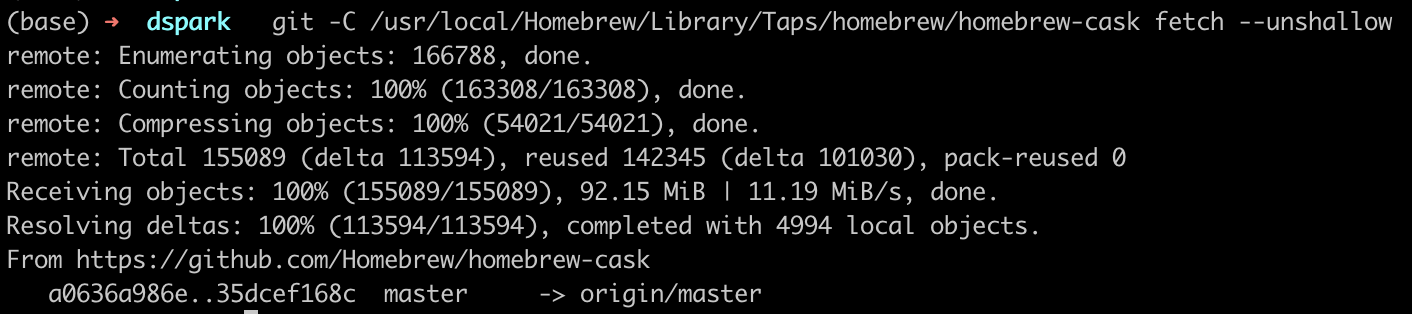

git -C /usr/local/Homebrew/Library/Taps/homebrew/homebrew-cask fetch --unshallow

(base) ➜ dspark brew install scala

tomcat@8 is keg-only, which means it was not symlinked into /usr/local,

because this is an alternate version of another formula.

If you need to have tomcat@8 first in your PATH, run:

echo 'export PATH="/usr/local/opt/tomcat@8/bin:$PATH"' >> ~/.zshrc

To restart tomcat@8 after an upgrade:

brew services restart tomcat@8

Or, if you don't want/need a background service you can just run:

/usr/local/opt/tomcat@8/bin/catalina run

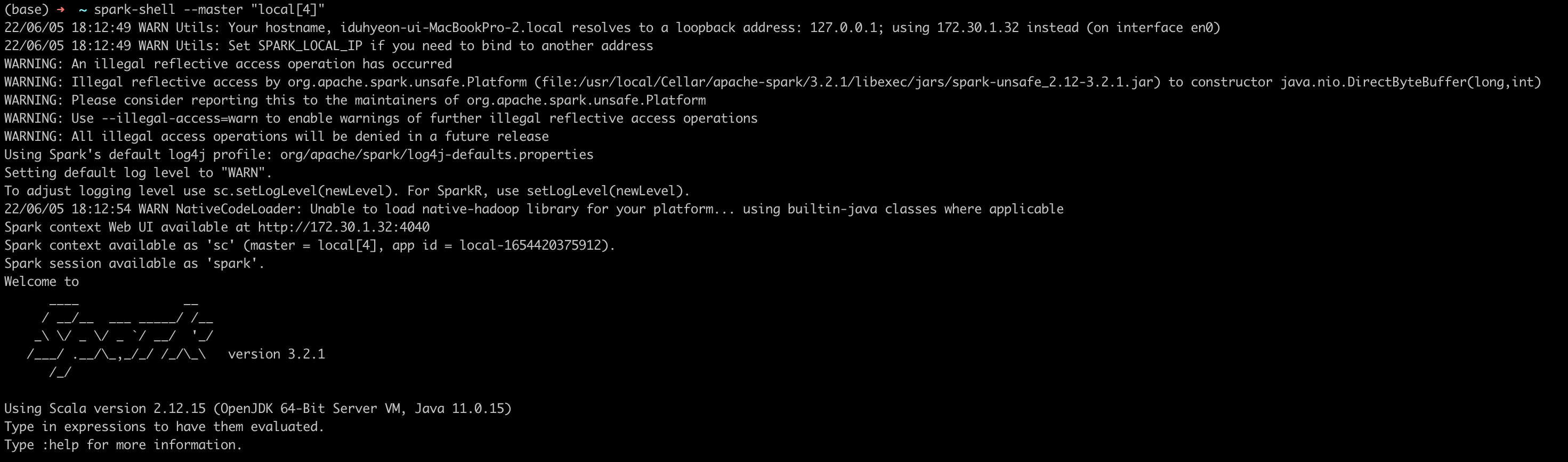

run spark-shell from the command line to launch Spark shell. You should see something like this below (ignore the warning for now). spark-shell is a CLI utility that comes with Apache Spark distribution.

단어 수 예의 경우 --master local[4] 이 스파크 셸의 스파크 컨텍스트가 4개의 스레드 가 있는 로컬 노드 에서 마스터 역할을 한다는 의미의 옵션으로 시작합니다.

|

$ spark-shell --master "local[4]"

|

export SPARK_HOME=/usr/local/Cellar/apache-spark/3.2.1/libexec

export PATH="$SPARK_HOME/bin/:$PATH"

spark-shell 명령어 입력해 CLI 화명 실행

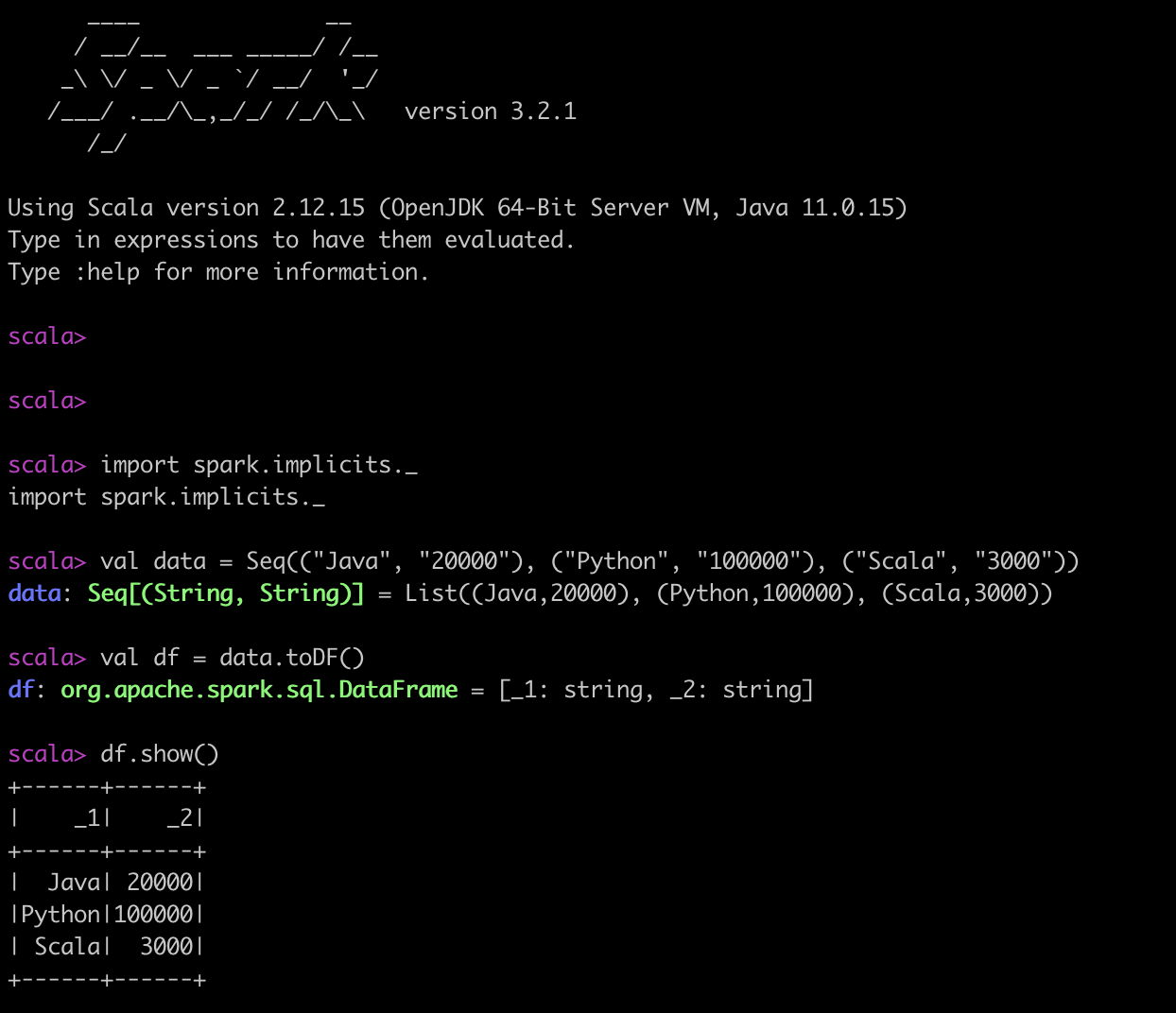

아래 내용 복사

import spark.implicits._

val data = Seq(("Java", "20000"), ("Python", "100000"), ("Scala", "3000"))

val df = data.toDF()

df.show()

다음은 어디로 갈까요?

Apache Spark 최신 버전을 성공적으로 설치했으므로 아래 문서를 따라 Spark 프레임워크에 대해 자세히 알아볼 수 있습니다.

- 스파크 RDD 튜토리얼

- Spark DataFrame 튜토리얼

- Scala 및 IntelliJ를 사용한 Apache Spark 설정

- IntelliJ IDEA의 Spark Hello World 예제

- Yarn이 있는 Hadoop 클러스터의 Spark 설정

- SparkSession이란 무엇이며 어떻게 생성합니까?

- SparkContext란 무엇이며 어떻게 생성합니까?

결론

이 기사에서는 Homebrew를 사용하여 Apache Spark 최신 버전을 단계별로 설치하는 방법을 배웠습니다. 단계에는 Homebrew, Java, Scala, Apache Spark 설치 및 spark-shell 실행을 통한 설치 검증이 포함됩니다.

'JAVA > etc.' 카테고리의 다른 글

| [java] Spark (0) | 2023.02.08 |

|---|---|

| sql (0) | 2022.04.16 |

| Maven 설치 - Mac OS (old version) (0) | 2022.02.28 |

| Nexus (0) | 2022.02.10 |

| [Pentaho] Transformation 1 (0) | 2021.12.02 |